Le premier hiver de l'IA : quand les premières promesses ont rencontré la réalité

Le premier "hiver de l'IA", s'étendant approximativement de 1974 à 1980, marque une période significative dans l'histoire de la recherche en intelligence artificielle. Ce fut une époque caractérisée par un déclin spectaculaire de l'enthousiasme, des financements et des progrès perçus, faisant suite à une ère d'optimisme intense durant les années 1950 et 1960. Au cours de ces décennies initiales, des pionniers ont fait des prédictions audacieuses concernant les capacités imminentes des machines pensantes, préparant le terrain pour une vague de désillusion lorsque la réalité n'a pas été à la hauteur.

Le début du premier hiver de l'IA n'est pas dû à un événement unique, mais plutôt à une confluence de facteurs. Ceux-ci comprenaient des promesses excessivement ambitieuses qui n'ont pas pu être tenues, des limitations fondamentales dans la technologie disponible et la compréhension théorique, ainsi que des critiques influentes qui ont remis en question les fondements mêmes et les progrès du domaine, conduisant finalement à de sévères coupes budgétaires.

Un "hiver de l'IA" désigne une période marquée par une réduction significative de l'intérêt et du financement pour la recherche en intelligence artificielle. Ces périodes sont souvent caractérisées par des cycles de battage médiatique excessif suivis d'une déception lorsque les résultats ne sont pas à la hauteur des attentes.

Facteurs clés ayant contribué au premier hiver de l'IA

Plusieurs problèmes critiques ont convergé pour déclencher ce ralentissement :

- Promesses excessives et attentes non satisfaites : Les premiers chercheurs en IA, encouragés par les succès initiaux dans des domaines limités (comme les jeux ou la logique simple), ont fait des prédictions très optimistes. Des figures comme Herbert Simon ont prédit, dans les années 1950 et 1960, que les machines seraient capables de faire tout le travail qu'un homme peut faire dans les vingt ans. Lorsque ces grandes visions ne se sont pas matérialisées – les machines ne pouvaient pas comprendre le langage naturel couramment, traduire avec précision ou faire preuve d'un raisonnement de bon sens général – la déception a grandi parmi les sponsors et le public.

- Obstacles techniques fondamentaux :

- L'explosion combinatoire : Les chercheurs ont découvert que de nombreux problèmes apparemment simples devenaient inextricables sur le plan computationnel à mesure que l'échelle augmentait. Les méthodes qui fonctionnaient pour des problèmes "jouets" simples ont échoué de manière spectaculaire sur des tâches du monde réel parce que le nombre de possibilités à explorer augmentait de façon exponentielle, submergeant les ressources informatiques disponibles.

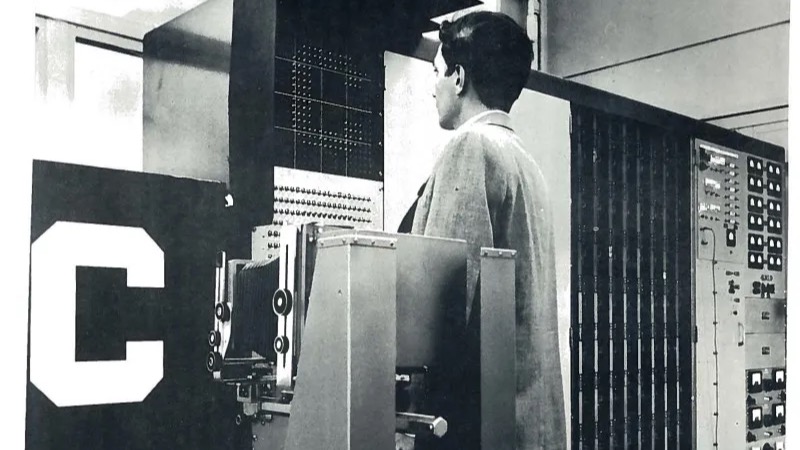

- Puissance de calcul et mémoire insuffisantes : Le matériel de l'époque, bien qu'en progression, n'était tout simplement pas assez puissant pour gérer les calculs complexes et les grandes quantités de données requises par les programmes d'IA plus ambitieux. La vitesse de traitement et la capacité de mémoire étaient des goulots d'étranglement majeurs.

- Manque de grands ensembles de données : Contrairement à l'environnement riche en données d'aujourd'hui, les chercheurs manquaient des grands ensembles de données numérisées nécessaires pour entraîner et tester efficacement les systèmes d'IA, en particulier pour des tâches comme la compréhension du langage ou la reconnaissance d'images.

- Limitations théoriques (par exemple, les perceptrons) : Bien qu'antérieur de peu à l'hiver principal, le livre "Perceptrons" de 1969 de Marvin Minsky et Seymour Papert a démontré mathématiquement les limitations fondamentales des réseaux neuronaux simples à une seule couche (le modèle connexionniste dominant à l'époque). Ils ont montré que ces réseaux ne pouvaient même pas résoudre des problèmes de base comme la fonction XOR, jetant le doute sur leur potentiel pour les tâches complexes et freinant considérablement l'enthousiasme pour la recherche sur les réseaux neuronaux pendant plus d'une décennie.

- Critiques dommageables et coupes budgétaires :

- Rapport ALPAC (1966, États-Unis) : Ce rapport du Comité consultatif sur le traitement automatique des langues (Automatic Language Processing Advisory Committee), commandé par les agences de financement américaines, a livré une évaluation très critique de la recherche sur la traduction automatique. Il a conclu que la traduction automatique était plus lente, moins précise et plus coûteuse que la traduction humaine et n'a vu aucune perspective de traduction pratique de haute qualité dans un avenir proche. Cela a conduit à des coupes drastiques dans le financement des projets de traduction automatique aux États-Unis.

- Rapport Lighthill (1973, Royaume-Uni) : Commandé par le British Science Research Council et rédigé par le mathématicien appliqué Sir James Lighthill, ce rapport a offert une vision pessimiste de la recherche en IA au Royaume-Uni. Il a soutenu que l'IA n'avait pas atteint ses grands objectifs et que ses méthodes étaient inadéquates pour résoudre des problèmes du monde réel en raison de problèmes comme l'explosion combinatoire. Le rapport a conduit à de sévères coupes dans le financement de la recherche en IA dans les universités britanniques, initiant effectivement l'hiver de l'IA au Royaume-Uni.

- Changement d'orientation de la DARPA (États-Unis) : La Defense Advanced Research Projects Agency (DARPA) américaine, principale source de financement de l'IA, est devenue de plus en plus frustrée par le manque de progrès concrets dans des domaines comme la compréhension de la parole (par exemple, le programme Speech Understanding Research à l'université Carnegie Mellon). Au début des années 1970, la DARPA a modifié sa stratégie de financement en faveur de projets plus dirigés, axés sur la mission, avec des objectifs à court terme clairement définis, réduisant ainsi le soutien à la recherche en IA plus exploratoire et non dirigée.

- Le paradoxe de Moravec émerge : Les chercheurs ont commencé à observer ce que Hans Moravec a articulé plus tard : les tâches faciles pour les humains (comme la perception, la mobilité, la reconnaissance de formes) se sont avérées incroyablement difficiles pour l'IA, tandis que les tâches difficiles pour les humains (comme les calculs complexes ou la déduction logique dans des domaines contraints) étaient relativement plus faciles pour les ordinateurs. Cela a mis en évidence le profond défi que représente la reproduction des compétences sensorielles et motrices humaines de base.

Source : Wikipédia

Impacts du gel

Le premier hiver de l'IA a eu des conséquences profondes pour le domaine :

- Réductions drastiques de financement : Les agences gouvernementales (comme la DARPA aux États-Unis et le SRC au Royaume-Uni) et les investisseurs privés ont considérablement réduit ou supprimé le financement de la recherche en IA.

- Annulations de projets et ralentissement : De nombreux projets d'IA ambitieux ont été arrêtés, et l'activité de recherche globale a considérablement ralenti.

- Changement d'orientation : Les chercheurs ont souvent réorienté leur attention vers des domaines plus appliqués de l'informatique avec des perspectives plus claires de résultats à court terme, ou ont rebaptisé leurs travaux en IA sous des étiquettes différentes (par exemple, reconnaissance de formes, informatique) pour obtenir des financements.

- Perte de talents : Certains chercheurs ont complètement quitté le domaine en raison du manque de financement et du manque de progrès perçu.

- Promotion du pragmatisme : Du côté positif, l'hiver a forcé les chercheurs restants à adopter des objectifs plus réalistes et des méthodologies rigoureuses. Il a encouragé les travaux sur des problèmes plus limités et des domaines fondamentaux comme la programmation logique, la représentation des connaissances et l'exploration de différents mécanismes de raisonnement (comme le raisonnement de bon sens) qui ont jeté les bases des avancées futures.

Figures clés et leurs rôles durant cette époque

- Marvin Minsky & Seymour Papert : Co-fondateurs du MIT AI Lab. Leur livre de 1969 "Perceptrons" a analysé de manière critique les premiers réseaux neuronaux, contribuant de manière significative au déclin de la recherche connexionniste qui a coïncidé avec le premier hiver.

- Sir James Lighthill : Auteur de l'influent Rapport Lighthill de 1973, qui a sévèrement critiqué la recherche en IA au Royaume-Uni et y a conduit à d'importantes coupes budgétaires.

- Herbert Simon & Allen Newell : Premiers pionniers de l'IA dont les prédictions optimistes sur les capacités de l'IA dans les années 50 et 60 ont contribué au cycle de battage médiatique initial.

- John McCarthy : A inventé le terme "intelligence artificielle" et a développé le langage de programmation LISP, qui est resté crucial pour la recherche en IA malgré l'hiver.

- Yehoshua Bar-Hillel : Un des premiers sceptiques, en particulier concernant la faisabilité d'une traduction automatique de haute qualité entièrement automatique, dont les arguments ont gagné du terrain jusqu'au rapport ALPAC.

- Roger Schank & Marvin Minsky : Plus tard, lors d'une conférence AAAI en 1984, ils ont explicitement mis en garde contre un "hiver de l'IA" imminent (se référant au deuxième hiver potentiel), établissant une analogie avec le concept d'hiver nucléaire et popularisant le terme pour décrire ces ralentissements.

Dégel et leçons apprises

Le premier hiver de l'IA n'a pas représenté un arrêt complet, mais plutôt un refroidissement et une réévaluation significatifs. La recherche s'est poursuivie dans des domaines spécifiques, souvent avec des affirmations moins ambitieuses. Les leçons apprises – la nécessité d'une puissance de calcul beaucoup plus grande, de plus grands ensembles de données, d'algorithmes plus sophistiqués et d'une fixation d'objectifs plus réaliste – ont été cruciales. Alors que le développement des systèmes experts a commencé à gagner du terrain vers la fin de cette période et au début des années 1980 (conduisant à un boom ultérieur et finalement au deuxième hiver de l'IA), la fin du premier hiver a été davantage un dégel progressif. Il a été caractérisé par une approche plus prudente et ciblée qui a lentement reconstruit la crédibilité et a ouvert la voie à la résurgence éventuelle de différents paradigmes de l'IA, y compris le regain d'intérêt pour l'apprentissage machine et les réseaux neuronaux des décennies plus tard, alimenté par la puissance de calcul et les données mêmes qui manquaient dans les années 1970.