Pourquoi NVIDIA domine-t-il le marché des GPU pour l'IA ?

L'essor de l'apprentissage automatique et des grands modèles de langage (LLM) a engendré des défis informatiques qui nécessitent bien plus que de simples mises à niveau matérielles. L'explosion de l'intelligence artificielle de ces dernières années a généré des demandes de calcul spécialisées auxquelles NVIDIA apporte actuellement des solutions quasi exclusives.

Les fondements de la supériorité technologique de NVIDIA

Solutions matérielles spécialisées

La clé du succès de NVIDIA réside dans le développement spécialisé de ses Cœurs Tensor. Ces unités matérielles dédiées effectuent non seulement des calculs parallèles, mais sont spécifiquement optimisées pour les opérations d'intelligence artificielle. Elles offrent trois avantages technologiques essentiels :

- Multiplication matricielle accélérée : Exécution extrêmement efficace de l'opération la plus cruciale dans les réseaux neuronaux.

- Calcul en précision mixte : Capacité de conversion en temps réel entre différents formats numériques, permettant d'augmenter la vitesse de calcul tout en conservant une précision acceptable, optimisant ainsi les performances et l'utilisation de la mémoire.

- Optimisations pour l'apprentissage profond : Prise en charge intégrée des opérations les plus courantes dans les réseaux neuronaux.

Écosystème logiciel

NVIDIA ne se contente pas de fabriquer du matériel ; elle fournit une infrastructure logicielle complète :

- Sa plateforme CUDA

- Les bibliothèques cuDNN

- Les outils d'optimisation TensorRT

- Un support développeur étendu

Cet écosystème mature et largement adopté simplifie considérablement le travail des développeurs et assure une utilisation maximale du matériel, créant ainsi une barrière à l'entrée substantielle pour les concurrents.

La position des concurrents

AMD se rapproche

La plateforme ROCm d'AMD (plateforme logicielle d'AMD similaire à CUDA) devient compétitive, mais elle est actuellement en retard sur NVIDIA :

- Fonctionnalités d'accélération matérielle spécifiques à l'IA limitées par rapport aux Cœurs Tensor.

- Écosystème logiciel moins mature.

- Communauté de développeurs plus petite.

- Matériel souvent plus rentable, offrant un compromis.

Intel investit massivement

Intel consacre des ressources importantes pour rattraper son retard avec son architecture GPU Xe et ses accélérateurs d'IA dédiés (comme la série Gaudi) :

- Investissements sérieux en R&D.

- Expérience prometteuse dans les semi-conducteurs.

- Les accélérateurs Gaudi 3 sont désormais disponibles et affichent des performances compétitives dans des tâches LLM spécifiques par rapport aux H100/H200 de NVIDIA, visant à conquérir des parts de marché, en particulier là où l'offre de NVIDIA est limitée.

- Continue de développer ses solutions matérielles et son écosystème d'IA par rapport à l'avance de NVIDIA.

Pourquoi tous les GPU ne conviennent-ils pas aux tâches d'IA ?

Limitations matérielles

- Manque de Cœurs Tensor

- Tous les GPU ne sont pas dotés de cœurs d'accélération d'IA dédiés.

- Les cartes de génération plus ancienne ne conviennent qu'au calcul à usage général.

- Type et taille de la mémoire

- Les grands LLM nécessitent au moins 40 à 80 Go de mémoire, tandis que les modèles avec des dizaines ou des centaines de milliards de paramètres nécessitent plusieurs fois cette valeur.

- Différences entre les technologies HBM (High Bandwidth Memory) et GDDR : la HBM offre généralement une bande passante plus élevée et est plus proche de la puce GPU, ce qui est essentiel pour les grands modèles, tandis que la GDDR est plus courante dans les cartes grand public.

- La bande passante est d'une importance capitale.

- Efficacité énergétique

- Les tâches d'IA sont extrêmement gourmandes en énergie.

- Toutes les cartes ne sont pas capables de dissiper efficacement la chaleur et de gérer une charge continue.

Compatibilité logicielle

- Tous les frameworks ne prennent pas en charge les différents GPU de manière égale.

- CUDA est devenu la norme de facto.

- Les alternatives open-source (comme ROCm) ont des limitations en termes de maturité et d'étendue du support, bien qu'elles s'améliorent.

Le rôle des GPU dans l'inférence LLM

Pendant la phase d'inférence des grands modèles de langage (LLM), les GPU (Graphics Processing Units) jouent un rôle clé en fournissant la puissance de calcul. Les opérations LLM sont basées sur de nombreux calculs matriciels qui nécessitent un traitement parallèle pour une exécution efficace. Les GPU, avec leurs milliers de cœurs, peuvent effectuer de grandes multiplications matricielles et d'autres opérations basées sur des tenseurs en parallèle, réduisant considérablement la latence d'inférence. Les architectures comme les Cœurs Tensor de NVIDIA ou les accélérateurs d'IA d'AMD sont spécifiquement optimisées pour les tâches d'apprentissage automatique, rendant l'exécution des LLM plus efficace.

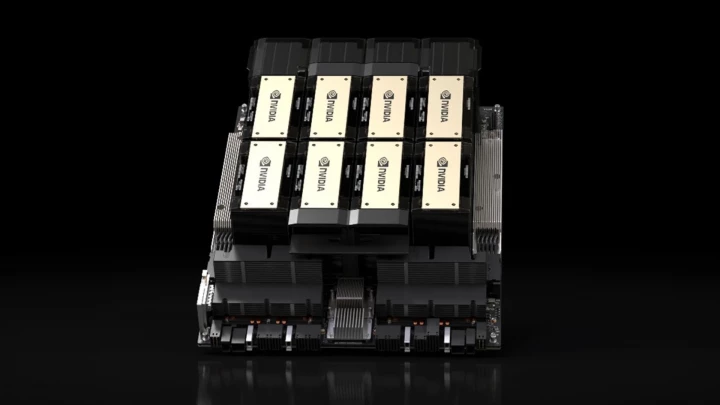

Les GPU sont avantageux non seulement pour les performances, mais aussi pour l'efficacité énergétique pendant l'inférence LLM. Bien que les CPU puissent également exécuter des LLM, les GPU produisent des résultats significativement plus rapides avec une consommation d'énergie inférieure en raison de leurs capacités de parallélisation largement supérieures. De plus, les solutions courantes dans les infrastructures d'IA modernes, telles que la mise à l'échelle multi-GPU ou les accélérateurs d'IA dédiés (par exemple, NVIDIA A100, H100, H200, série AMD Instinct MI300, Intel Gaudi 3), améliorent encore la vitesse de traitement, permettant une utilisation en temps réel ou quasi réel des LLM dans les chatbots, les moteurs de recherche et d'autres applications basées sur l'IA.

Principaux GPU NVIDIA pour l'inférence LLM

| Modèle de GPU | Architecture | Marché cible | Génération de Cœurs Tensor | Cœurs CUDA | Cœurs Tensor | Mémoire | Bande passante mémoire | Consommation électrique (TDP) |

|---|---|---|---|---|---|---|---|---|

| NVIDIA H200 SXM | Hopper | Centre de données | 4e | 16 896 | 528 | 141 Go HBM3e | 4,8 To/s | Jusqu'à 700 W |

| NVIDIA H100 SXM | Hopper | Centre de données | 4e | 16 896 | 528 | 80 Go HBM3 | 3,35 To/s | Jusqu'à 700 W |

| NVIDIA A100 (80 Go) | Ampere | Centre de données | 3e | 6 912 | 432 | 80 Go HBM2e | ~2 To/s | 400 W |

| NVIDIA L40S | Ada Lovelace | Centre de données | 4e | 18 176 | 568 | 48 Go GDDR6 | 0,86 To/s | 350 W |

| NVIDIA T4 | Turing | Centre de données | 2e | 2 560 | 320 | 16 Go GDDR6 | 0,32 To/s | 70 W |

| NVIDIA Tesla P40 | Pascal | Centre de données | N/A | 3 840 | N/A | 24 Go GDDR5 | 0,34 To/s | 250 W |

| NVIDIA RTX 5090 | Blackwell | Grand public / Prosumer | 5e | 21 760 | 680 | 32 Go GDDR7 | 1,79 To/s | 575 W |

| NVIDIA RTX 4090 | Ada Lovelace | Grand public / Prosumer | 4e | 16 384 | 512 | 24 Go GDDR6X | 1 To/s | 450 W |

Remarque : Les spécifications telles que le nombre de cœurs CUDA/Tensor peuvent varier légèrement entre les modèles de cartes spécifiques (par exemple, SXM vs. PCIe). Les valeurs indiquées sont typiques ou maximales pour le modèle/architecture indiqué. Le nombre de Cœurs Tensor du RTX 5090 est estimé.

Avantages et inconvénients

| Modèle de GPU | Avantages | Inconvénients |

| NVIDIA H200/H100 | - Performances maximales pour les LLM massifs - Capacité mémoire et bande passante énormes (HBM) | - Coût extrêmement élevé - Consommation électrique et chaleur élevées |

| NVIDIA A100 | - Excellentes performances, largement adopté - Toujours très performant pour de nombreux modèles | - Toujours cher - Consommation électrique élevée |

| NVIDIA L40S | - Performances élevées pour l'inférence/le graphisme - Meilleur rapport prix/performance que le H100 pour certaines tâches - Plus économe en énergie que le haut de gamme | - Bande passante mémoire inférieure (GDDR6) - Représente toujours un investissement important |

| NVIDIA RTX 5090 / 4090 | - Excellent rapport qualité/prix - Facilement disponible (marché grand public) - Relativement abordable pour la puissance | - Capacité mémoire plus petite que les cartes de centre de données - Non conçu pour un fonctionnement continu en centre de données (pilotes, refroidissement, limitations de support) |

| NVIDIA T4 | - Faible consommation électrique - Rentable pour l'inférence - Largement pris en charge sur les plateformes cloud | - Performances brutes inférieures - Mémoire limitée |

Critères de sélection

Lors du choix du GPU approprié, tenez compte de :

- La taille du ou des modèles que vous prévoyez d'exécuter

- Les exigences de performance (latence, débit)

- Le budget disponible

- Les capacités d'alimentation et de refroidissement

Stratégies d'optimisation des coûts

- Mettre à l'échelle l'infrastructure en fonction des besoins réels (ne pas surdimensionner).

- Utiliser un traitement par lots efficace et une inférence en précision mixte.

- Optimiser l'architecture du modèle (si possible).

- Appliquer des techniques de compression de modèle (quantification, élagage).

- Envisager les ressources GPU basées sur le cloud par rapport à la construction d'une infrastructure sur site.

Adéquation des GPU pour les tâches d'IA

| Catégorie | Adéquation | Critères clés |

|---|---|---|

| Excellent (Haut de gamme) | H200, H100, A100 (80 Go) | - 80+ Go de mémoire à large bande passante (HBM3e/HBM3/HBM2e) - Cœurs Tensor dédiés de dernière génération - Conçu pour une extension massive |

| Très bon | L40S, RTX 5090 | - 32-48 Go de mémoire (GDDR7/GDDR6) |

| Bon | A100 (40 Go), RTX 4090, T4 | - 16-40 Go de mémoire |

| Limité | Anciens GPU de jeu (par exemple, RTX série 30, anciens Tesla comme P40) | - Moins de mémoire (souvent < 24 Go) - Cœurs spécifiques à l'IA anciens ou manquants - Bande passante mémoire inférieure |

| Non adapté | Graphiques intégrés, GPU très anciens | - Mémoire minimale - Manque de capacité de calcul parallèle / fonctionnalités d'IA |

Résumé

NVIDIA n'est actuellement pas seulement un fabricant de GPU, mais le créateur de tout un écosystème d'IA. Son avantage technologique ne réside pas dans une solution matérielle unique, mais dans un système complexe et intégré combinant un matériel de pointe avec une plateforme logicielle mature et largement adoptée.