Почему NVIDIA доминирует на рынке AI GPU?

Развитие машинного обучения и больших языковых моделей (LLM) создало вычислительные задачи, которые требуют гораздо большего, чем простое обновление оборудования. Взрывной рост искусственного интеллекта в последние годы породил специализированные вычислительные потребности, для которых NVIDIA в настоящее время предлагает практически эксклюзивные решения.

Истоки технологического превосходства NVIDIA

Специализированные аппаратные решения

Ключ к успеху NVIDIA заключается в специализированной разработке тензорных ядер. Эти выделенные аппаратные блоки не только выполняют параллельные вычисления, но и специально оптимизированы для операций искусственного интеллекта. Они предлагают три важнейших технологических преимущества:

- Ускоренное матричное умножение: Чрезвычайно эффективное выполнение наиболее важной операции в нейронных сетях.

- Вычисления смешанной точности: Способность конвертировать между различными числовыми форматами в реальном времени, что позволяет увеличить вычислительную скорость, сохраняя при этом приемлемую точность, оптимизируя производительность и использование памяти.

- Оптимизации для глубокого обучения: Встроенная поддержка наиболее распространенных операций в нейронных сетях.

Программная экосистема

NVIDIA не просто производит оборудование; она предоставляет полную программную инфраструктуру:

- Платформа CUDA

- Библиотеки cuDNN

- Инструменты оптимизации TensorRT

- Обширная поддержка разработчиков

Эта зрелая и широко распространенная экосистема значительно упрощает работу разработчиков и обеспечивает максимальное использование аппаратного обеспечения, создавая существенный барьер для входа конкурентов.

Позиция конкурентов

AMD нагоняет

Платформа ROCm от AMD (программная платформа AMD, аналогичная CUDA) становится конкурентоспособной, но в настоящее время отстает от NVIDIA:

- Ограниченные аппаратные функции ускорения AI по сравнению с Tensor Cores.

- Менее зрелая программная экосистема.

- Меньшее сообщество разработчиков.

- Часто более экономичное оборудование, предлагающее компромисс.

Intel делает крупные инвестиции

Intel направляет значительные ресурсы на то, чтобы догнать конкурентов, с помощью своей архитектуры GPU Xe и специализированных AI-ускорителей (таких как серия Gaudi):

- Серьезные инвестиции в исследования и разработки.

- Многообещающий опыт в полупроводниковой отрасли.

- Ускорители Gaudi 3 теперь доступны и демонстрируют конкурентоспособную производительность в определенных задачах LLM по сравнению с NVIDIA H100/H200, стремясь захватить долю рынка, особенно там, где поставки NVIDIA ограничены.

- Все еще разрабатывает свои аппаратные решения и экосистему для AI по сравнению с лидерством NVIDIA.

Почему не все GPU подходят для задач AI?

Аппаратные ограничения

- Отсутствие тензорных ядер

- Не все GPU имеют выделенные ядра для ускорения AI.

- Видеокарты старого поколения подходят только для вычислений общего назначения.

- Тип и объем памяти

- Большим LLM требуется не менее 40-80 ГБ памяти, а моделям с десятками или сотнями миллиардов параметров требуется кратно больше.

- Различия между технологиями HBM (память с высокой пропускной способностью) и GDDR: HBM обычно предлагает более высокую пропускную способность и находится ближе к чипу GPU, что критически важно для больших моделей, в то время как GDDR более распространена в потребительских картах.

- Пропускная способность имеет критически важное значение.

- Энергоэффективность

- Задачи AI чрезвычайно энергоемки.

- Не все карты способны эффективно рассеивать тепло и справляться с непрерывной нагрузкой.

Программная совместимость

- Не все фреймворки поддерживают разные GPU одинаково.

- CUDA стала стандартом де-факто.

- Открытые альтернативы (такие как ROCm) имеют ограничения в зрелости и широте поддержки, хотя они и улучшаются.

Роль GPU в выводе LLM

Во время фазы вывода больших языковых моделей (LLM) графические процессоры (GPU) играют ключевую роль в обеспечении вычислительной мощности. Операции LLM основаны на многочисленных матричных вычислениях, которые требуют параллельной обработки для эффективного выполнения. GPU, с их тысячами ядер, могут выполнять большие матричные умножения и другие тензорные операции параллельно, значительно снижая задержку вывода. Архитектуры, такие как Tensor Cores от NVIDIA или AI-ускорители от AMD, специально оптимизированы для задач машинного обучения, что делает выполнение LLM более эффективным.

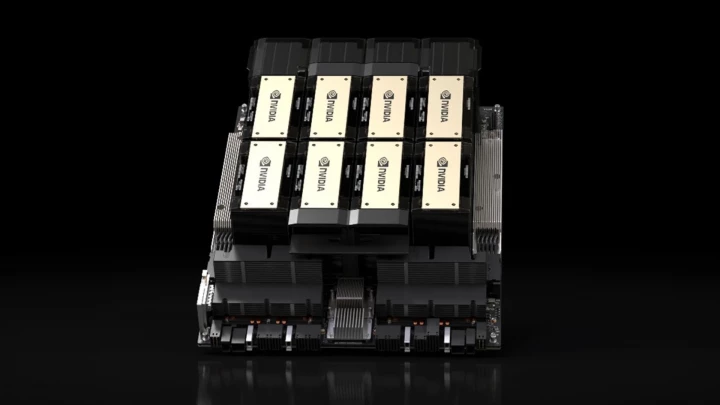

GPU выгодны не только с точки зрения производительности, но и с точки зрения энергоэффективности во время вывода LLM. Хотя процессоры CPU также могут запускать LLM, GPU обеспечивают значительно более быстрые результаты при более низком энергопотреблении благодаря своим значительно превосходящим возможностям параллелизации. Кроме того, распространенные решения в современных AI-инфраструктурах, такие как масштабирование с использованием нескольких GPU или выделенные AI-ускорители (например, NVIDIA A100, H100, H200, серия AMD Instinct MI300, Intel Gaudi 3), еще больше повышают скорость обработки, обеспечивая использование LLM в режиме реального времени или почти в реальном времени в чат-ботах, поисковых системах и других приложениях на основе AI.

Ключевые GPU NVIDIA для вывода LLM

| Модель GPU | Архитектура | Целевой рынок | Поколение тензорных ядер | Ядра CUDA | Тензорные ядра | Память | Пропускная способность памяти | Энергопотребление (TDP) |

|---|---|---|---|---|---|---|---|---|

| NVIDIA H200 SXM | Hopper | Дата-центр | 4-е | 16 896 | 528 | 141 ГБ HBM3e | 4,8 ТБ/с | До 700 Вт |

| NVIDIA H100 SXM | Hopper | Дата-центр | 4-е | 16 896 | 528 | 80 ГБ HBM3 | 3,35 ТБ/с | До 700 Вт |

| NVIDIA A100 (80GB) | Ampere | Дата-центр | 3-е | 6 912 | 432 | 80 ГБ HBM2e | ~2 ТБ/с | 400 Вт |

| NVIDIA L40S | Ada Lovelace | Дата-центр | 4-е | 18 176 | 568 | 48 ГБ GDDR6 | 0,86 ТБ/с | 350 Вт |

| NVIDIA T4 | Turing | Дата-центр | 2-е | 2 560 | 320 | 16 ГБ GDDR6 | 0,32 ТБ/с | 70 Вт |

| NVIDIA Tesla P40 | Pascal | Дата-центр | Н/Д | 3 840 | Н/Д | 24 ГБ GDDR5 | 0,34 ТБ/с | 250 Вт |

| NVIDIA RTX 5090 | Blackwell | Потребительский / Prosumer | 5-е | 21 760 | 680 | 32 ГБ GDDR7 | 1,79 ТБ/с | 575 Вт |

| NVIDIA RTX 4090 | Ada Lovelace | Потребительский / Prosumer | 4-е | 16 384 | 512 | 24 ГБ GDDR6X | 1 ТБ/с | 450 Вт |

Примечание: Спецификации, такие как количество ядер CUDA/Tensor, могут незначительно отличаться между конкретными моделями карт (например, SXM vs. PCIe). Показанные значения являются типичными или максимальными для указанной модели/архитектуры. Количество тензорных ядер RTX 5090 является оценочным.

Плюсы и минусы

| Модель GPU | Плюсы | Минусы |

| NVIDIA H200/H100 | - Пиковая производительность для массивных LLM - Огромная емкость и пропускная способность памяти (HBM) | - Чрезвычайно высокая стоимость - Высокое энергопотребление и тепловыделение |

| NVIDIA A100 | - Отличная производительность, широко распространена - Все еще очень способна для многих моделей | - Все еще дорого - Высокое энергопотребление |

| NVIDIA L40S | - Высокая производительность для вывода/графики - Лучшее соотношение цена/производительность, чем у H100 для некоторых задач - Более энергоэффективна, чем топовые модели | - Более низкая пропускная способность памяти (GDDR6) - Все еще значительные инвестиции |

| NVIDIA RTX 5090 / 4090 | - Отличное соотношение цены и производительности - Легко доступны (потребительский рынок) - Относительно доступны по цене за такую мощность | - Меньшая емкость памяти по сравнению с картами для дата-центров - Не предназначены для непрерывной работы в дата-центрах (драйверы, охлаждение, ограничения поддержки) |

| NVIDIA T4 | - Низкое энергопотребление - Экономически эффективна для вывода - Широко поддерживается на облачных платформах | - Более низкая общая производительность - Ограниченная память |

Критерии выбора

При выборе подходящего GPU учитывайте:

- Размер модели(ей), которые вы планируете запускать

- Требования к производительности (задержка, пропускная способность)

- Доступный бюджет

- Возможности электропитания и охлаждения

Стратегии оптимизации затрат

- Масштабируйте инфраструктуру в соответствии с фактическими потребностями (не перегружайте).

- Используйте эффективную пакетную обработку и вывод со смешанной точностью.

- Оптимизируйте архитектуру модели (если возможно).

- Применяйте методы сжатия моделей (квантование, обрезка).

- Рассмотрите облачные GPU-ресурсы вместо создания локальной инфраструктуры.

Пригодность GPU для задач AI

| Категория | Пригодность | Ключевые критерии |

|---|---|---|

| Отлично (высший уровень) | H200, H100, A100 (80GB) | - 80+ ГБ памяти с высокой пропускной способностью (HBM3e/HBM3/HBM2e) - Тензорные ядра последнего поколения - Разработаны для массового масштабирования |

| Очень хорошо | L40S, RTX 5090 | - 32-48 ГБ памяти (GDDR7/GDDR6) |

| Хорошо | A100 (40GB), RTX 4090, T4 | - 16-40 ГБ памяти |

| Ограниченно | Старые игровые GPU (например, серия RTX 30, старые Tesla, такие как P40) | - Меньше памяти (часто < 24 ГБ) - Более старые или отсутствующие AI-специфические ядра - Более низкая пропускная способность памяти |

| Не подходят | Интегрированная графика, очень старые GPU | - Минимальный объем памяти - Недостаток возможностей параллельных вычислений / функций AI |

Резюме

NVIDIA в настоящее время является не просто производителем GPU, но и создателем целой AI-экосистемы. Ее технологическое преимущество заключается не в каком-то одном аппаратном решении, а в сложной, интегрированной системе, сочетающей передовое оборудование со зрелой и широко распространенной программной платформой.