Der erste KI-Winter: Als frühe Versprechen auf die Realität trafen

Der erste „KI-Winter“, der grob von 1974 bis 1980 dauerte, markiert eine bedeutende Periode in der Geschichte der Forschung zur künstlichen Intelligenz. Es war eine Zeit, die durch einen dramatischen Rückgang an Enthusiasmus, Finanzierung und wahrgenommenem Fortschritt gekennzeichnet war, und zwar nach einer Ära intensiven Optimismus in den 1950er und 1960er Jahren. In diesen ersten Jahrzehnten stellten Pioniere kühne Vorhersagen über die unmittelbar bevorstehenden Fähigkeiten denkender Maschinen auf und bereiteten so die Bühne für eine nachfolgende Welle der Ernüchterung, als die Realität hinter den Erwartungen zurückblieb.

Der Beginn des ersten KI-Winters war nicht auf ein einzelnes Ereignis zurückzuführen, sondern auf ein Zusammenwirken von Faktoren. Dazu gehörten übermäßig ehrgeizige Versprechen, die nicht gehalten werden konnten, grundlegende Beschränkungen der verfügbaren Technologie und des theoretischen Verständnisses sowie einflussreiche Kritiken, die die Grundlagen und den Fortschritt des Feldes in Frage stellten, was letztendlich zu drastischen Kürzungen der Mittel führte.

Ein „KI-Winter“ bezeichnet eine Periode, die durch eine signifikante Reduzierung des Interesses und der Finanzierung für die Forschung im Bereich der künstlichen Intelligenz gekennzeichnet ist. Diese Perioden sind oft durch Zyklen übermäßigen Hypes gefolgt von Enttäuschung gekennzeichnet, wenn die Ergebnisse die Erwartungen nicht erfüllen.

Schlüsselfaktoren, die zum ersten KI-Winter beitrugen

Mehrere kritische Probleme kamen zusammen und lösten diesen Abschwung aus:

- Überzogene Versprechen und Nichterfüllung von Erwartungen: Frühe KI-Forscher, ermutigt durch anfängliche Erfolge in begrenzten Bereichen (wie z. B. beim Spielen von Spielen oder einfacher Logik), stellten höchst optimistische Vorhersagen auf. Persönlichkeiten wie Herbert Simon sagten in den späten 1950er und 1960er Jahren bekanntlich voraus, dass Maschinen innerhalb von zwanzig Jahren jede Arbeit erledigen könnten, die ein Mensch erledigen kann. Als diese großen Visionen nicht verwirklicht wurden – Maschinen konnten natürliche Sprache nicht fließend verstehen, nicht genau übersetzen oder kein allgemeines, vernünftiges Denken zeigen –, wuchs die Enttäuschung bei Sponsoren und der Öffentlichkeit.

- Fundamentale technische Hürden:

- Die kombinatorische Explosion: Forscher entdeckten, dass viele scheinbar einfache Probleme rechnerisch unlösbar wurden, je größer der Umfang wurde. Methoden, die bei einfachen „Spielzeug“-Problemen funktionierten, scheiterten bei realen Aufgaben spektakulär, weil die Anzahl der zu untersuchenden Möglichkeiten exponentiell wuchs und die verfügbaren Rechenressourcen überwältigte.

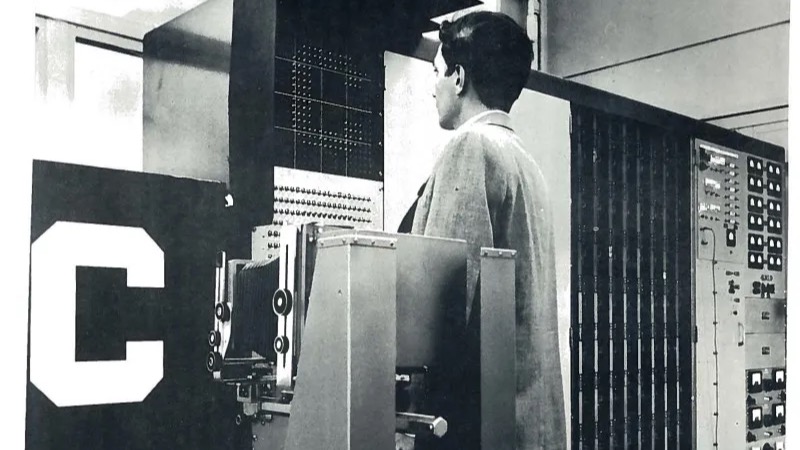

- Unzureichende Rechenleistung und Speicherkapazität: Die Hardware der damaligen Zeit war, obwohl sie sich weiterentwickelte, einfach nicht leistungsfähig genug, um die komplexen Berechnungen und großen Datenmengen zu bewältigen, die für anspruchsvollere KI-Programme erforderlich waren. Verarbeitungsgeschwindigkeit und Speicherkapazität waren große Engpässe.

- Mangel an großen Datensätzen: Anders als in der heutigen datenreichen Umgebung fehlten den Forschern die großen, digitalisierten Datensätze, die für das effektive Training und Testen von KI-Systemen erforderlich sind, insbesondere für Aufgaben wie das Sprachverständnis oder die Bilderkennung.

- Theoretische Einschränkungen (z. B. Perzeptrone): Das Buch „Perceptrons“ von Marvin Minsky und Seymour Papert aus dem Jahr 1969, das dem eigentlichen Winter zwar leicht vorausging, demonstrierte mathematisch die grundlegenden Einschränkungen einfacher, einschichtiger neuronaler Netze (des damals dominierenden konnektionistischen Modells). Sie zeigten, dass diese Netze nicht einmal grundlegende Probleme wie die XOR-Funktion lösen konnten, was Zweifel an ihrem Potenzial für komplexe Aufgaben aufkommen ließ und den Enthusiasmus für die Forschung an neuronalen Netzen für mehr als ein Jahrzehnt erheblich dämpfte.

- Schädliche Kritik und Mittelkürzungen:

- ALPAC-Bericht (1966, USA): Dieser Bericht des Automatic Language Processing Advisory Committee, der von US-amerikanischen Förderagenturen in Auftrag gegeben wurde, lieferte eine höchst kritische Bewertung der Forschung zur maschinellen Übersetzung. Er kam zu dem Schluss, dass die maschinelle Übersetzung langsamer, ungenauer und teurer sei als die menschliche Übersetzung und sah keine Aussicht auf eine praktische, qualitativ hochwertige Übersetzung in naher Zukunft. Dies führte zu drastischen Kürzungen der Mittel für Projekte zur maschinellen Übersetzung in den USA.

- Der Lighthill-Bericht (1973, UK): Dieser Bericht, der vom British Science Research Council in Auftrag gegeben und vom angewandten Mathematiker Sir James Lighthill verfasst wurde, bot eine pessimistische Sicht auf die KI-Forschung in Großbritannien. Er argumentierte, dass die KI ihre großen Ziele nicht erreicht habe und dass ihre Methoden aufgrund von Problemen wie der kombinatorischen Explosion ungeeignet seien, um reale Probleme zu lösen. Der Bericht führte zu massiven Kürzungen der Mittel für die KI-Forschung an britischen Universitäten und leitete damit faktisch den KI-Winter in Großbritannien ein.

- DARPAs Fokusverschiebung (USA): Die US Defense Advanced Research Projects Agency (DARPA), eine Hauptquelle für KI-Mittel, war zunehmend frustriert über den mangelnden konkreten Fortschritt in Bereichen wie dem Sprachverständnis (z. B. dem Speech Understanding Research-Programm an der Carnegie Mellon University). In den frühen 1970er Jahren verlagerte die DARPA ihre Förderstrategie hin zu stärker zielgerichteten, missionsorientierten Projekten mit klar definierten, kurzfristigen Zielen und kürzte die Unterstützung für explorativere, ungerichtete KI-Forschung.

- Moravecs Paradox taucht auf: Forscher begannen zu beobachten, was Hans Moravec später formulierte: Aufgaben, die für Menschen einfach sind (wie Wahrnehmung, Mobilität, Mustererkennung), erwiesen sich für die KI als unglaublich schwierig, während Aufgaben, die für Menschen schwierig sind (wie komplexe Berechnungen oder logische Ableitungen in begrenzten Bereichen), für Computer relativ einfacher waren. Dies verdeutlichte die große Herausforderung, grundlegende menschliche sensorische und motorische Fähigkeiten zu replizieren.

Quelle: Wikipédia

Auswirkungen des Stillstands

Der erste KI-Winter hatte tiefgreifende Folgen für das Feld:

- Drastische Mittelkürzungen: Regierungsbehörden (wie DARPA in den USA und SRC in Großbritannien) und private Investoren reduzierten oder strichen die Mittel für die KI-Forschung erheblich.

- Projektabbrüche und Verlangsamung: Viele ehrgeizige KI-Projekte wurden eingestellt, und die gesamte Forschungsaktivität verlangsamte sich erheblich.

- Fokusverschiebung: Forscher verlagerten ihren Fokus oft auf stärker angewandte Bereiche der Informatik mit klareren Aussichten auf kurzfristige Ergebnisse oder gaben ihrer KI-Arbeit unter anderen Bezeichnungen (z. B. Mustererkennung, Informatik) ein neues Image, um sich Mittel zu sichern.

- Verlust von Talenten: Einige Forscher verließen das Feld aufgrund des Mangels an Mitteln und des wahrgenommenen Mangels an Fortschritt ganz.

- Förderung des Pragmatismus: Positiv zu vermerken ist, dass der Winter die verbliebenen Forscher zwang, sich realistischere Ziele und rigorosere Methoden zu setzen. Er förderte die Arbeit an stärker eingegrenzten Problemen und grundlegenden Bereichen wie der logischen Programmierung, der Wissensrepräsentation und der Erforschung verschiedener Schlussfolgerungsmechanismen (wie z. B. dem Common-Sense-Reasoning), die den Grundstein für zukünftige Fortschritte legten.

Schlüsselfiguren und ihre Rollen in dieser Ära

- Marvin Minsky & Seymour Papert: Mitbegründer des MIT AI Lab. Ihr Buch „Perceptrons“ aus dem Jahr 1969 analysierte frühe neuronale Netze kritisch und trug maßgeblich zum Rückgang der konnektionistischen Forschung bei, der mit dem ersten Winter zusammenfiel.

- Sir James Lighthill: Autor des einflussreichen Lighthill-Berichts von 1973, der die britische KI-Forschung stark kritisierte und dort zu massiven Mittelkürzungen führte.

- Herbert Simon & Allen Newell: Frühe KI-Pioniere, deren optimistische Vorhersagen über die Fähigkeiten der KI in den 50er und 60er Jahren zum anfänglichen Hype-Zyklus beitrugen.

- John McCarthy: Prägte den Begriff „künstliche Intelligenz“ und entwickelte die Programmiersprache LISP, die trotz des Winters für die KI-Forschung von entscheidender Bedeutung blieb.

- Yehoshua Bar-Hillel: Ein früher Skeptiker, insbesondere hinsichtlich der Machbarkeit einer vollautomatischen, qualitativ hochwertigen maschinellen Übersetzung, dessen Argumente im Vorfeld des ALPAC-Berichts an Bedeutung gewannen.

- Roger Schank & Marvin Minsky: Später, auf einer AAAI-Konferenz im Jahr 1984, warnten sie explizit vor einem drohenden „KI-Winter“ (bezogen auf den potenziellen zweiten Winter), zogen eine Analogie zum Konzept eines nuklearen Winters und popularisierten den Begriff, um diese Abschwünge zu beschreiben.

Auftauen und Lehren

Der erste KI-Winter stellte keinen vollständigen Stillstand dar, sondern eher eine signifikante Abkühlung und Neubewertung. Die Forschung wurde in bestimmten Bereichen fortgesetzt, oft mit weniger ehrgeizigen Behauptungen. Die gewonnenen Erkenntnisse – die Notwendigkeit einer weitaus größeren Rechenleistung, größerer Datensätze, ausgefeilterer Algorithmen und einer realistischeren Zielsetzung – waren entscheidend. Während die Entwicklung von Expertensystemen gegen Ende dieser Periode und in den frühen 1980er Jahren an Zugkraft gewann (was zu einem anschließenden Boom und schließlich zum zweiten KI-Winter führte), war das Ende des ersten Winters eher ein allmähliches Auftauen. Es war durch einen vorsichtigeren, fokussierteren Ansatz gekennzeichnet, der langsam die Glaubwürdigkeit wiederherstellte und den Weg für das eventuelle Wiederaufleben verschiedener KI-Paradigmen ebnete, einschließlich des erneuten Interesses an maschinellem Lernen und neuronalen Netzen Jahrzehnte später, das durch die Rechenleistung und Datenmengen befeuert wurde, die in den 1970er Jahren fehlten.