El Primer Invierno de la IA: Cuando las Primeras Promesas se Toparon con la Realidad

El primer "Invierno de la IA", que abarcó aproximadamente de 1974 a 1980, marca un período significativo en la historia de la investigación en inteligencia artificial. Fue una época caracterizada por una disminución drástica del entusiasmo, la financiación y el progreso percibido, tras una era de intenso optimismo durante las décadas de 1950 y 1960. Durante esas décadas iniciales, los pioneros hicieron predicciones audaces sobre las capacidades inminentes de las máquinas pensantes, preparando el escenario para una ola posterior de desilusión cuando la realidad no estuvo a la altura.

El inicio del primer Invierno de la IA no se debió a un solo evento, sino a una confluencia de factores. Estos incluyeron promesas demasiado ambiciosas que no pudieron cumplirse, limitaciones fundamentales en la tecnología disponible y la comprensión teórica, y críticas influyentes que cuestionaron los fundamentos mismos y el progreso del campo, lo que finalmente condujo a severos recortes de financiación.

Un "Invierno de la IA" significa un período marcado por una reducción significativa en el interés y la financiación para la investigación en inteligencia artificial. Estos períodos a menudo se caracterizan por ciclos de bombo excesivo seguido de decepción cuando los resultados no cumplen con las expectativas.

Factores Clave que Contribuyeron al Primer Invierno de la IA

Varios problemas críticos convergieron para desencadenar esta recesión:

- Promesas Exageradas y Expectativas Incumplidas: Los primeros investigadores de IA, impulsados por los éxitos iniciales en dominios limitados (como juegos o lógica simple), hicieron predicciones muy optimistas. Figuras como Herbert Simon predijeron famosamente a finales de las décadas de 1950 y 1960 que las máquinas serían capaces de hacer cualquier trabajo que un hombre pudiera hacer en veinte años. Cuando estas grandes visiones no se materializaron (las máquinas no podían entender el lenguaje natural con fluidez, traducir con precisión o exhibir un razonamiento de sentido común general), la decepción creció entre los patrocinadores y el público.

- Obstáculos Técnicos Fundamentales:

- La Explosión Combinatoria: Los investigadores descubrieron que muchos problemas aparentemente sencillos se volvían computacionalmente intratables a medida que aumentaba la escala. Los métodos que funcionaban para problemas simples de "juguete" fallaban estrepitosamente en tareas del mundo real porque el número de posibilidades a explorar crecía exponencialmente, superando los recursos informáticos disponibles.

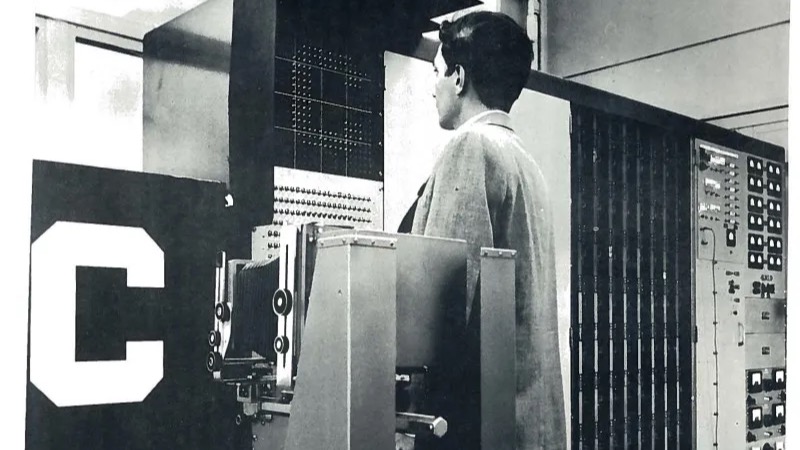

- Potencia de Computación y Memoria Insuficientes: El hardware de la época, aunque avanzado, simplemente no era lo suficientemente potente como para manejar los cálculos complejos y las grandes cantidades de datos requeridos por programas de IA más ambiciosos. La velocidad de procesamiento y la capacidad de memoria fueron importantes cuellos de botella.

- Falta de Grandes Conjuntos de Datos: A diferencia del entorno rico en datos actual, los investigadores carecían de los grandes conjuntos de datos digitalizados necesarios para entrenar y probar eficazmente los sistemas de IA, particularmente para tareas como la comprensión del lenguaje o el reconocimiento de imágenes.

- Limitaciones Teóricas (p. ej., Perceptrones): Aunque es ligeramente anterior al invierno principal, el libro de 1969 "Perceptrons" de Marvin Minsky y Seymour Papert demostró matemáticamente las limitaciones fundamentales de las redes neuronales simples de una sola capa (el modelo conexionista dominante en ese momento). Demostraron que estas redes ni siquiera podían resolver problemas básicos como la función XOR, lo que generó dudas sobre su potencial para tareas complejas y disminuyó significativamente el entusiasmo por la investigación en redes neuronales durante más de una década.

- Críticas Perjudiciales y Recortes de Financiación:

- Informe ALPAC (1966, EE. UU.): Este informe del Comité Asesor de Procesamiento Automático del Lenguaje, encargado por las agencias de financiación de EE. UU., entregó una evaluación muy crítica de la investigación en traducción automática. Concluyó que la traducción automática era más lenta, menos precisa y más cara que la traducción humana y no veía perspectivas de una traducción práctica y de alta calidad en el futuro cercano. Esto llevó a recortes drásticos en la financiación de proyectos de traducción automática en los EE. UU.

- El Informe Lighthill (1973, Reino Unido): Encargado por el Consejo de Investigación Científica Británico y escrito por el matemático aplicado Sir James Lighthill, este informe ofreció una visión pesimista de la investigación de la IA en el Reino Unido. Argumentó que la IA no había logrado sus grandes objetivos y que sus métodos eran inadecuados para resolver problemas del mundo real debido a problemas como la explosión combinatoria. El informe condujo a severos recortes en la financiación de la investigación de la IA en las universidades británicas, iniciando efectivamente el invierno de la IA en el Reino Unido.

- Cambio de Enfoque de DARPA (EE. UU.): La Agencia de Proyectos de Investigación Avanzada de Defensa de EE. UU. (DARPA), una fuente principal de financiación de la IA, se frustró cada vez más con la falta de progreso concreto en áreas como la comprensión del habla (p. ej., el programa de Investigación de Comprensión del Habla en la Universidad Carnegie Mellon). A principios de la década de 1970, DARPA cambió su estrategia de financiación hacia proyectos más dirigidos y orientados a misiones con objetivos claramente definidos a corto plazo, recortando el apoyo a la investigación de IA más exploratoria y no dirigida.

- Surge la Paradoja de Moravec: Los investigadores comenzaron a observar lo que Hans Moravec articuló más tarde: tareas fáciles para los humanos (como la percepción, la movilidad, el reconocimiento de patrones) resultaron increíblemente difíciles para la IA, mientras que las tareas difíciles para los humanos (como los cálculos complejos o la deducción lógica en dominios restringidos) fueron relativamente más fáciles para las computadoras. Esto destacó el profundo desafío de replicar las habilidades sensoriales y motoras humanas básicas.

Fuente: Wikipédia

Impactos de la Congelación

El primer Invierno de la IA tuvo profundas consecuencias para el campo:

- Reducciones Drásticas de Financiación: Las agencias gubernamentales (como DARPA en EE. UU. y el SRC en el Reino Unido) y los inversores privados redujeron o eliminaron significativamente la financiación para la investigación en IA.

- Cancelaciones y Ralentización de Proyectos: Muchos proyectos ambiciosos de IA fueron cancelados y la actividad de investigación general se ralentizó considerablemente.

- Cambio de Enfoque: Los investigadores a menudo cambiaron su enfoque a áreas más aplicadas de la informática con perspectivas más claras de resultados a corto plazo, o renombraron su trabajo de IA bajo diferentes etiquetas (p. ej., reconocimiento de patrones, informática) para asegurar la financiación.

- Pérdida de Talento: Algunos investigadores abandonaron el campo por completo debido a la falta de financiación y la percepción de falta de progreso.

- Fomento del Pragmatismo: En el lado positivo, el invierno obligó a los investigadores restantes a adoptar objetivos más realistas y metodologías rigurosas. Fomentó el trabajo en problemas más limitados y áreas fundamentales como la programación lógica, la representación del conocimiento y la exploración de diferentes mecanismos de razonamiento (como el razonamiento de sentido común) que sentaron las bases para futuros avances.

Figuras Clave y sus Roles Durante Esta Era

- Marvin Minsky y Seymour Papert: Cofundadores del Laboratorio de IA del MIT. Su libro de 1969 "Perceptrons" analizó críticamente las primeras redes neuronales, contribuyendo significativamente a la disminución de la investigación conexionista que coincidió con el primer invierno.

- Sir James Lighthill: Autor del influyente Informe Lighthill de 1973, que criticó severamente la investigación de IA en el Reino Unido y condujo a importantes recortes de financiación allí.

- Herbert Simon y Allen Newell: Pioneros tempranos de la IA cuyas predicciones optimistas sobre las capacidades de la IA en las décadas de 1950 y 1960 contribuyeron al ciclo de bombo inicial.

- John McCarthy: Acuñó el término "inteligencia artificial" y desarrolló el lenguaje de programación LISP, que siguió siendo crucial para la investigación de la IA a pesar del invierno.

- Yehoshua Bar-Hillel: Un escéptico temprano, particularmente con respecto a la viabilidad de la traducción automática de alta calidad totalmente automática, cuyos argumentos ganaron fuerza antes del informe ALPAC.

- Roger Schank y Marvin Minsky: Más tarde, en una conferencia de la AAAI de 1984, advirtieron explícitamente sobre un "Invierno de la IA" inminente (refiriéndose al potencial segundo invierno), trazando una analogía con el concepto de invierno nuclear y popularizando el término para describir estas recesiones.

Descongelación y Lecciones Aprendidas

El primer Invierno de la IA no representó una paralización completa, sino más bien un enfriamiento y una reevaluación significativos. La investigación continuó en áreas específicas, a menudo con afirmaciones menos ambiciosas. Las lecciones aprendidas (la necesidad de una potencia informática mucho mayor, conjuntos de datos más grandes, algoritmos más sofisticados y un establecimiento de objetivos más realista) fueron cruciales. Si bien el desarrollo de sistemas expertos comenzó a ganar tracción hacia el final de este período y a principios de la década de 1980 (lo que llevó a un auge posterior y eventualmente al segundo Invierno de la IA), el final del primer invierno fue más bien una descongelación gradual. Se caracterizó por un enfoque más cauteloso y centrado que reconstruyó lentamente la credibilidad y allanó el camino para el eventual resurgimiento de diferentes paradigmas de la IA, incluido el renovado interés en el aprendizaje automático y las redes neuronales décadas después, impulsado por la misma potencia computacional y datos que faltaban en la década de 1970.