¿Por qué NVIDIA Domina el Mercado de las GPU para IA?

El avance del aprendizaje automático y los modelos de lenguaje grandes (LLM) ha generado desafíos computacionales que requieren mucho más que simples actualizaciones de hardware. La explosión de la inteligencia artificial en los últimos años ha creado demandas de computación especializadas para las cuales NVIDIA ofrece actualmente soluciones casi exclusivas.

Las Raíces de la Superioridad Tecnológica de NVIDIA

Soluciones de Hardware Especializado

La clave del éxito de NVIDIA reside en el desarrollo especializado de sus Tensor Cores. Estas unidades de hardware dedicadas no solo realizan computaciones en paralelo, sino que están específicamente optimizadas para operaciones de inteligencia artificial. Ofrecen tres ventajas tecnológicas críticas:

- Multiplicación de Matrices Acelerada: Ejecución extremadamente eficiente de la operación más crucial en redes neuronales.

- Computación de Precisión Mixta: Capaz de convertir entre diferentes formatos numéricos en tiempo real, lo que permite aumentar la velocidad computacional manteniendo una precisión aceptable, optimizando el rendimiento y el uso de memoria.

- Optimizaciones para Aprendizaje Profundo: Soporte integrado para las operaciones más comunes en redes neuronales.

Ecosistema de Software

NVIDIA no solo fabrica hardware; proporciona una infraestructura de software completa:

- Su plataforma CUDA

- Bibliotecas cuDNN

- Herramientas de optimización TensorRT

- Amplio soporte para desarrolladores

Este ecosistema maduro y ampliamente adoptado simplifica significativamente el trabajo de los desarrolladores y garantiza la máxima utilización del hardware, creando una barrera de entrada sustancial para los competidores.

La Posición de los Competidores

AMD se Está Poniendo al Día

La plataforma ROCm de AMD (plataforma de software de AMD similar a CUDA) se está volviendo competitiva, pero actualmente está por detrás de NVIDIA:

- Funciones limitadas de aceleración de hardware específicas para IA en comparación con los Tensor Cores.

- Ecosistema de software menos maduro.

- Comunidad de desarrolladores más pequeña.

- Hardware a menudo más rentable, ofreciendo una compensación.

Intel Está Invirtiendo Fuertemente

Intel está canalizando importantes recursos para alcanzar a NVIDIA con su arquitectura de GPU Xe y aceleradores de IA dedicados (como la serie Gaudi):

- Serias inversiones en I+D.

- Experiencia prometedora en semiconductores.

- Los aceleradores Gaudi 3 ya están disponibles y muestran un rendimiento competitivo en tareas específicas de LLM contra los H100/H200 de NVIDIA, con el objetivo de capturar cuota de mercado, especialmente donde el suministro de NVIDIA es limitado.

- Aún está desarrollando sus soluciones de hardware y ecosistema de IA en comparación con el liderazgo de NVIDIA.

¿Por Qué No Todas Las GPU Son Adecuadas Para Tareas de IA?

Limitaciones de Hardware

- Falta de Tensor Cores

- No todas las GPU tienen núcleos aceleradores de IA dedicados.

- Las tarjetas de generaciones anteriores solo son adecuadas para computación de propósito general.

- Tipo y Tamaño de la Memoria

- Los LLM grandes requieren al menos 40-80 GB de memoria, mientras que los modelos con decenas o cientos de miles de millones de parámetros necesitan múltiplos de este valor.

- Diferencias entre las tecnologías HBM (Memoria de Ancho de Banda Alto) y GDDR: HBM típicamente ofrece un mayor ancho de banda y está más cerca del chip de la GPU, crítico para modelos grandes, mientras que GDDR es más común en tarjetas de consumo.

- El ancho de banda es críticamente importante.

- Eficiencia Energética

- Las tareas de IA son extremadamente intensivas en energía.

- No todas las tarjetas son capaces de disipar el calor de manera eficiente y manejar una carga continua.

Compatibilidad de Software

- No todos los frameworks soportan diferentes GPU por igual.

- CUDA se ha convertido en el estándar de facto.

- Las alternativas de código abierto (como ROCm) tienen limitaciones en madurez y amplitud de soporte, aunque están mejorando.

El Rol de las GPU en la Inferencia de LLM

Durante la fase de inferencia de modelos de lenguaje grandes (LLM), las GPU (Unidades de Procesamiento Gráfico) juegan un papel clave al proporcionar potencia computacional. Las operaciones de LLM se basan en numerosos cálculos matriciales que requieren procesamiento en paralelo para una ejecución eficiente. Las GPU, con sus miles de núcleos, pueden realizar grandes multiplicaciones de matrices y otras operaciones basadas en tensores en paralelo, reduciendo significativamente la latencia de inferencia. Arquitecturas como Tensor Cores de NVIDIA o aceleradores de IA de AMD están específicamente optimizadas para tareas de aprendizaje automático, haciendo que la ejecución de LLM sea más eficiente.

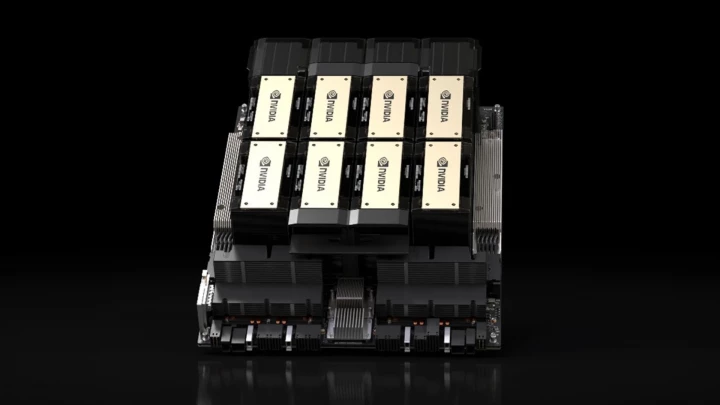

Las GPU son ventajosas no solo por el rendimiento sino también por la eficiencia energética durante la inferencia de LLM. Si bien las CPU también pueden ejecutar LLM, las GPU producen resultados significativamente más rápidos con un menor consumo de energía debido a sus capacidades de paralelización enormemente superiores. Además, las soluciones comunes en las infraestructuras modernas de IA, como el escalado multi-GPU o los aceleradores de IA dedicados (p. ej., NVIDIA A100, H100, H200, AMD Instinct serie MI300, Intel Gaudi 3), mejoran aún más la velocidad de procesamiento, permitiendo el uso en tiempo real o casi en tiempo real de LLM en chatbots, motores de búsqueda y otras aplicaciones basadas en IA.

GPU Clave de NVIDIA para la Inferencia de LLM

| Modelo de GPU | Arquitectura | Mercado Objetivo | Generación de Tensor Core | Núcleos CUDA | Tensor Cores | Memoria | Ancho de Banda de Memoria | Consumo de Energía (TDP) |

|---|---|---|---|---|---|---|---|---|

| NVIDIA H200 SXM | Hopper | Centro de Datos | 4ª | 16,896 | 528 | 141GB HBM3e | 4.8 TB/s | Hasta 700W |

| NVIDIA H100 SXM | Hopper | Centro de Datos | 4ª | 16,896 | 528 | 80GB HBM3 | 3.35 TB/s | Hasta 700W |

| NVIDIA A100 (80GB) | Ampere | Centro de Datos | 3ª | 6,912 | 432 | 80GB HBM2e | ~2 TB/s | 400W |

| NVIDIA L40S | Ada Lovelace | Centro de Datos | 4ª | 18,176 | 568 | 48GB GDDR6 | 0.86 TB/s | 350W |

| NVIDIA T4 | Turing | Centro de Datos | 2ª | 2,560 | 320 | 16GB GDDR6 | 0.32 TB/s | 70W |

| NVIDIA Tesla P40 | Pascal | Centro de Datos | N/A | 3,840 | N/A | 24 GB GDDR5 | 0.34 TB/s | 250W |

| NVIDIA RTX 5090 | Blackwell | Consumidor / Prosumidor | 5ª | 21,760 | 680 | 32GB GDDR7 | 1.79 TB/s | 575W |

| NVIDIA RTX 4090 | Ada Lovelace | Consumidor / Prosumidor | 4ª | 16,384 | 512 | 24GB GDDR6X | 1 TB/s | 450W |

Nota: Especificaciones como el conteo de núcleos CUDA/Tensor pueden variar ligeramente entre modelos de tarjeta específicos (p. ej., SXM vs. PCIe). Los valores mostrados son típicos o máximos para el modelo/arquitectura indicado. El conteo de Tensor Cores de RTX 5090 es estimado.

Pros y Contras

| Modelo de GPU | Pros | Contras |

| NVIDIA H200/H100 | - Rendimiento máximo para LLM masivos - Gran capacidad de memoria y ancho de banda (HBM) | - Costo extremadamente alto - Alto consumo de energía y calor |

| NVIDIA A100 | - Excelente rendimiento, ampliamente adoptada - Sigue siendo muy capaz para muchos modelos | - Sigue siendo cara - Alto consumo de energía |

| NVIDIA L40S | - Sólido rendimiento para inferencia/gráficos - Mejor relación precio/rendimiento que H100 para algunas tareas - Más eficiente energéticamente que las de nivel superior | - Menor ancho de banda de memoria (GDDR6) - Sigue siendo una inversión significativa |

| NVIDIA RTX 5090 / 4090 | - Excelente relación precio-rendimiento - Fácilmente disponibles (mercado de consumo) - Relativamente asequibles para la potencia | - Menor capacidad de memoria vs. tarjetas de centro de datos - No diseñadas para operación continua en centro de datos (drivers, refrigeración, limitaciones de soporte) |

| NVIDIA T4 | - Bajo consumo de energía - Rentable para inferencia - Ampliamente soportada en plataformas en la nube | - Menor rendimiento bruto - Memoria limitada |

Criterios de Selección

Al elegir la GPU adecuada, considere:

- El tamaño del modelo(s) que planea ejecutar

- Requisitos de rendimiento (latencia, rendimiento)

- Presupuesto disponible

- Capacidades de suministro de energía y refrigeración

Estrategias de Optimización de Costos

- Escale la infraestructura según las necesidades reales (no sobreaprovisione).

- Utilice procesamiento por lotes eficiente e inferencia de precisión mixta.

- Optimice la arquitectura del modelo (si es posible).

- Aplique técnicas de compresión de modelos (cuantización, poda).

- Considere los recursos de GPU basados en la nube frente a la construcción de infraestructura local.

Idoneidad de las GPU para Tareas de IA

| Categoría | Idoneidad | Criterios Clave |

|---|---|---|

| Excelente (Nivel Superior) | H200, H100, A100 (80GB) | - 80+ GB de Memoria de Ancho de Banda Alto (HBM3e/HBM3/HBM2e) - Tensor Cores dedicados de última generación - Diseñadas para escalado masivo |

| Muy Buena | L40S, RTX 5090 | - 32-48 GB de Memoria (GDDR7/GDDR6) |

| Buena | A100 (40GB), RTX 4090, T4 | - 16-40 GB de Memoria |

| Limitada | GPU de juegos más antiguas (p. ej., serie RTX 30, Teslas más antiguas como P40) | - Menos memoria (a menudo < 24GB) - Núcleos más antiguos o sin núcleos específicos para IA - Menor ancho de banda de memoria |

| No Adecuada | Gráficos integrados, GPU muy antiguas | - Memoria mínima - Falta de capacidad de computación paralela / funciones de IA |

Resumen

NVIDIA no es actualmente solo un fabricante de GPU, sino el creador de un ecosistema de IA completo. Su ventaja tecnológica no reside en una única solución de hardware, sino en un sistema complejo e integrado que combina hardware de vanguardia con una plataforma de software madura y ampliamente adoptada.