为什么英伟达在 AI GPU 市场占据主导地位?

机器学习和大型语言模型 (LLM) 的进步带来了计算挑战,这些挑战需要的不仅仅是简单的硬件升级。近年来人工智能的爆发式增长产生了对专业计算的巨大需求,而英伟达目前几乎为这些需求提供了独家解决方案。

英伟达技术优势的根源

专业化硬件解决方案

英伟达成功的关键在于其 Tensor Core 的专业化开发。这些专用硬件单元不仅执行并行计算,而且专门针对人工智能运算进行了优化。它们提供了三个关键的技术优势:

- 加速矩阵乘法:极其高效地执行神经网络中最关键的运算。

- 混合精度计算:能够在不同数值格式之间实时转换,从而在保持可接受精度的同时提高计算速度,优化性能和内存使用。

- 深度学习优化:内置支持神经网络中最常见的运算。

软件生态系统

英伟达不仅仅制造硬件;它还提供完整的软件基础设施:

- 其 CUDA 平台

- cuDNN 库

- TensorRT 优化工具

- 广泛的开发者支持

这个成熟且被广泛采用的生态系统极大地简化了开发人员的工作,并确保了硬件的最大利用率,为竞争对手设置了巨大的进入壁垒。

竞争对手的处境

AMD 正在迎头赶上

AMD 的 ROCm 平台(AMD 的软件平台,类似于 CUDA)正变得具有竞争力,但目前仍落后于英伟达:

- 与 Tensor Core 相比,AI 专用硬件加速功能有限。

- 软件生态系统成熟度较低。

- 开发者社区规模较小。

- 硬件通常更具成本效益,提供了一种权衡方案。

英特尔正在大力投资

英特尔正在投入大量资源以赶上其 Xe GPU 架构和专用 AI 加速器(如 Gaudi 系列):

- 大量的研发投资。

- 前景广阔的半导体经验。

- Gaudi 3 加速器现已上市,在特定的 LLM 任务中展现出与英伟达 H100/H200 相媲美的性能,旨在抢占市场份额,尤其是在英伟达供应受限的情况下。

- 与其领先的英伟达相比,其 AI 硬件解决方案和生态系统仍在开发中。

为什么并非所有 GPU 都适用于 AI 任务?

硬件限制

- 缺少 Tensor Core

- 并非所有 GPU 都具有专用的 AI 加速器核心。

- 老一代显卡仅适用于通用计算。

- 内存类型和大小

- 大型 LLM 至少需要 40-80 GB 的内存,而具有数百亿或数千亿参数的模型则需要数倍于此的值。

- HBM(高带宽内存)和 GDDR 技术之间的差异:HBM 通常提供更高的带宽,并且更靠近 GPU 芯片,这对于大型模型至关重要,而 GDDR 在消费级显卡中更常见。

- 带宽至关重要。

- 能源效率

- AI 任务非常耗能。

- 并非所有显卡都能够有效地散热和处理持续负载。

软件兼容性

- 并非所有框架都同等地支持不同的 GPU。

- CUDA 已成为事实上的标准。

- 开源替代方案(如 ROCm)在成熟度和支持广度方面存在局限性,尽管它们正在改进。

GPU 在 LLM 推理中的作用

在大型语言模型 (LLM) 的推理阶段,GPU(图形处理器)在提供计算能力方面发挥着关键作用。LLM 运算基于大量的矩阵计算,这些计算需要并行处理才能高效执行。GPU 拥有数千个核心,可以并行执行大型矩阵乘法和其他基于张量的运算,从而显著减少推理延迟。像英伟达的 Tensor Core 或 AMD 的 AI 加速器这样的架构专门针对机器学习任务进行了优化,从而使 LLM 的执行更加高效。

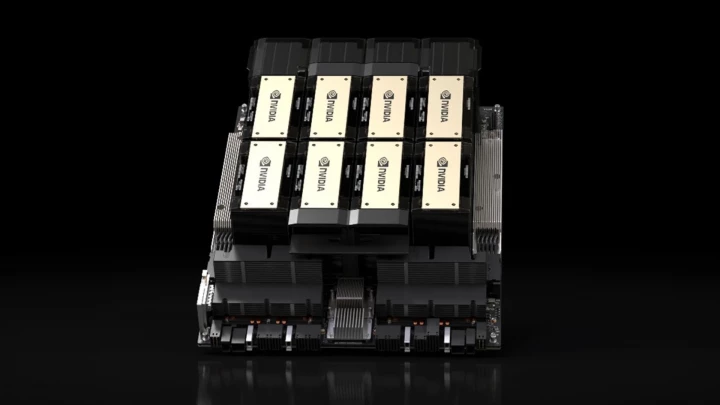

GPU 不仅在性能方面具有优势,而且在 LLM 推理期间的能源效率方面也具有优势。虽然 CPU 也可以运行 LLM,但由于 GPU 具有远超 CPU 的并行化能力,因此可以更快地产生结果,同时功耗更低。此外,现代 AI 基础设施中的常见解决方案,例如多 GPU 扩展或专用 AI 加速器(例如,英伟达 A100、H100、H200、AMD Instinct MI300 系列、英特尔 Gaudi 3),进一步提高了处理速度,使 LLM 能够在聊天机器人、搜索引擎和其他基于 AI 的应用程序中实现实时或近乎实时的使用。

用于 LLM 推理的关键英伟达 GPU

| GPU 型号 | 架构 | 目标市场 | Tensor Core 代 | CUDA 核心 | Tensor Core | 内存 | 内存带宽 | 功耗 (TDP) |

|---|---|---|---|---|---|---|---|---|

| NVIDIA H200 SXM | Hopper | 数据中心 | 第 4 代 | 16,896 | 528 | 141GB HBM3e | 4.8 TB/s | 高达 700W |

| NVIDIA H100 SXM | Hopper | 数据中心 | 第 4 代 | 16,896 | 528 | 80GB HBM3 | 3.35 TB/s | 高达 700W |

| NVIDIA A100 (80GB) | Ampere | 数据中心 | 第 3 代 | 6,912 | 432 | 80GB HBM2e | ~2 TB/s | 400W |

| NVIDIA L40S | Ada Lovelace | 数据中心 | 第 4 代 | 18,176 | 568 | 48GB GDDR6 | 0.86 TB/s | 350W |

| NVIDIA T4 | Turing | 数据中心 | 第 2 代 | 2,560 | 320 | 16GB GDDR6 | 0.32 TB/s | 70W |

| NVIDIA Tesla P40 | Pascal | 数据中心 | N/A | 3,840 | N/A | 24 GB GDDR5 | 0.34 TB/s | 250W |

| NVIDIA RTX 5090 | Blackwell | 消费级 / 轻量级专业 | 第 5 代 | 21,760 | 680 | 32GB GDDR7 | 1.79 TB/s | 575W |

| NVIDIA RTX 4090 | Ada Lovelace | 消费级 / 轻量级专业 | 第 4 代 | 16,384 | 512 | 24GB GDDR6X | 1 TB/s | 450W |

注意:CUDA/Tensor 核心计数等规格可能因特定显卡型号(例如,SXM 与 PCIe)而略有不同。显示的值是所示型号/架构的典型值或最大值。RTX 5090 Tensor Core 计数为估计值。

优点和缺点

| GPU 型号 | 优点 | 缺点 |

| NVIDIA H200/H100 | - 针对大规模 LLM 的峰值性能 - 巨大的内存容量和带宽 (HBM) | - 极高的成本 - 高功耗和发热量 |

| NVIDIA A100 | - 出色的性能,被广泛采用 - 对于许多模型仍然非常强大 | - 仍然昂贵 - 高功耗 |

| NVIDIA L40S | - 强大的推理/图形性能 - 对于某些任务,性价比高于 H100 - 比顶级产品更节能 | - 内存带宽较低 (GDDR6) - 仍然是一项 значительные 投资 |

| NVIDIA RTX 5090 / 4090 | - 出色的性价比 - 易于获得(消费市场) - 对于这种性能来说相对实惠 | - 与数据中心显卡相比,内存容量较小 - 并非为连续数据中心运行而设计(驱动程序、散热、支持限制) |

| NVIDIA T4 | - 低功耗 - 推理方面具有成本效益 - 在云平台上得到广泛支持 | - 原始性能较低 - 内存有限 |

选择标准

在选择合适的 GPU 时,请考虑:

- 您计划运行的模型的大小

- 性能要求(延迟、吞吐量)

- 可用预算

- 电源和散热能力

成本优化策略

- 根据实际需求扩展基础设施(不要过度配置)。

- 使用高效的批量处理和混合精度推理。

- 优化模型架构(如果可能)。

- 应用模型压缩技术(量化、剪枝)。

- 考虑基于云的 GPU 资源与构建本地基础设施。

GPU 对 AI 任务的适用性

| 类别 | 适用性 | 关键标准 |

|---|---|---|

| 优秀(顶级) | H200, H100, A100 (80GB) | - 80GB 以上的高带宽内存 (HBM3e/HBM3/HBM2e) - 最新一代专用 Tensor Core - 专为大规模扩展而设计 |

| 非常好 | L40S, RTX 5090 | - 32-48 GB 内存 (GDDR7/GDDR6) |

| 良好 | A100 (40GB), RTX 4090, T4 | - 16-40 GB 内存 |

| 有限 | 较旧的游戏 GPU(例如,RTX 30 系列,较旧的 Tesla,如 P40) | - 内存较少(通常 < 24GB) - 较旧或缺少 AI 专用核心 - 内存带宽较低 |

| 不适用 | 集成显卡,非常旧的 GPU | - 内存极小 - 缺乏并行计算能力/AI 功能 |

总结

英伟达目前不仅仅是一家 GPU 制造商,而是整个 AI 生态系统的创建者。其技术优势不在于单一的硬件解决方案,而在于一个复杂的集成系统,该系统将尖端的硬件与成熟且被广泛采用的软件平台相结合。