Warum dominiert NVIDIA den Markt für KI-GPUs?

Der Fortschritt im Bereich des maschinellen Lernens und großer Sprachmodelle (LLMs) hat rechenintensive Herausforderungen geschaffen, die weit mehr als einfache Hardware-Upgrades erfordern. Die explosionsartige Zunahme der künstlichen Intelligenz in den letzten Jahren hat spezielle Anforderungen an die Rechenleistung hervorgebracht, für die NVIDIA derzeit nahezu exklusive Lösungen anbietet.

Die Wurzeln der technologischen Überlegenheit von NVIDIA

Spezialisierte Hardwarelösungen

Der Schlüssel zum Erfolg von NVIDIA liegt in der spezialisierten Entwicklung seiner Tensor-Kerne. Diese dedizierten Hardware-Einheiten führen nicht nur parallele Berechnungen durch, sondern sind auch speziell für Operationen im Bereich der künstlichen Intelligenz optimiert. Sie bieten drei entscheidende technologische Vorteile:

- Beschleunigte Matrixmultiplikation: Extrem effiziente Ausführung der wichtigsten Operation in neuronalen Netzen.

- Gemischtpräzisionsrechnen: Fähigkeit zur Echtzeitkonvertierung zwischen verschiedenen numerischen Formaten, was eine höhere Rechengeschwindigkeit bei gleichbleibend akzeptabler Genauigkeit ermöglicht und so Leistung und Speichernutzung optimiert.

- Deep-Learning-Optimierungen: Integrierte Unterstützung für die gängigsten Operationen in neuronalen Netzen.

Software-Ökosystem

NVIDIA produziert nicht nur Hardware, sondern bietet auch eine vollständige Software-Infrastruktur:

- Seine CUDA-Plattform

- cuDNN-Bibliotheken

- TensorRT-Optimierungstools

- Umfassende Entwicklerunterstützung

Dieses ausgereifte und weit verbreitete Ökosystem vereinfacht die Arbeit von Entwicklern erheblich und gewährleistet eine maximale Hardwareauslastung, wodurch eine erhebliche Markteintrittsbarriere für Wettbewerber entsteht.

Die Position der Wettbewerber

AMD holt auf

Die ROCm-Plattform von AMD (die Softwareplattform von AMD, ähnlich wie CUDA) wird wettbewerbsfähiger, hinkt aber derzeit noch hinter NVIDIA her:

- Begrenzte KI-spezifische Hardwarebeschleunigungsfunktionen im Vergleich zu Tensor-Kernen.

- Weniger ausgereiftes Software-Ökosystem.

- Kleinere Entwickler-Community.

- Oft kostengünstigere Hardware, die einen Kompromiss bietet.

Intel investiert massiv

Intel investiert erhebliche Ressourcen, um mit seiner Xe-GPU-Architektur und dedizierten KI-Beschleunigern (wie der Gaudi-Serie) aufzuholen:

- Erhebliche Investitionen in Forschung und Entwicklung.

- Vielversprechende Halbleitererfahrung.

- Gaudi-3-Beschleuniger sind jetzt verfügbar und zeigen eine wettbewerbsfähige Leistung bei bestimmten LLM-Aufgaben im Vergleich zu NVIDIAs H100/H200, mit dem Ziel, Marktanteile zu gewinnen, insbesondere dort, wo das Angebot von NVIDIA begrenzt ist.

- Entwickelt seine KI-Hardwarelösungen und sein Ökosystem im Vergleich zu NVIDIAs Vorsprung noch weiter.

Warum sind nicht alle GPUs für KI-Aufgaben geeignet?

Hardware-Einschränkungen

- Fehlen von Tensor-Kernen

- Nicht alle GPUs verfügen über dedizierte KI-Beschleunigungskerne.

- Karten älterer Generationen sind nur für allgemeine Rechenaufgaben geeignet.

- Speichertyp und -größe

- Große LLMs benötigen mindestens 40-80 GB Speicher, während Modelle mit zig oder hunderten von Milliarden Parametern ein Vielfaches dieses Werts benötigen.

- Unterschiede zwischen HBM- (High Bandwidth Memory) und GDDR-Technologien: HBM bietet typischerweise eine höhere Bandbreite und ist näher am GPU-Chip, was für große Modelle entscheidend ist, während GDDR in Consumer-Karten häufiger vorkommt.

- Bandbreite ist von entscheidender Bedeutung.

- Energieeffizienz

- KI-Aufgaben sind extrem energieintensiv.

- Nicht alle Karten sind in der Lage, Wärme effizient abzuleiten und Dauerlast zu bewältigen.

Software-Kompatibilität

- Nicht alle Frameworks unterstützen verschiedene GPUs gleichermaßen.

- CUDA hat sich zum De-facto-Standard entwickelt.

- Open-Source-Alternativen (wie ROCm) weisen Einschränkungen in Bezug auf Reife und Breite der Unterstützung auf, verbessern sich aber.

Die Rolle von GPUs bei der LLM-Inferenz

Während der Inferenzphase großer Sprachmodelle (LLMs) spielen GPUs (Graphics Processing Units) eine Schlüsselrolle bei der Bereitstellung von Rechenleistung. LLM-Operationen basieren auf zahlreichen Matrixberechnungen, die eine parallele Verarbeitung für eine effiziente Ausführung erfordern. GPUs können mit ihren Tausenden von Kernen große Matrixmultiplikationen und andere tensorbasierte Operationen parallel ausführen, wodurch die Inferenzlatenz erheblich reduziert wird. Architekturen wie NVIDIAs Tensor-Kerne oder AMDs KI-Beschleuniger sind speziell für Aufgaben des maschinellen Lernens optimiert, wodurch die LLM-Ausführung effizienter wird.

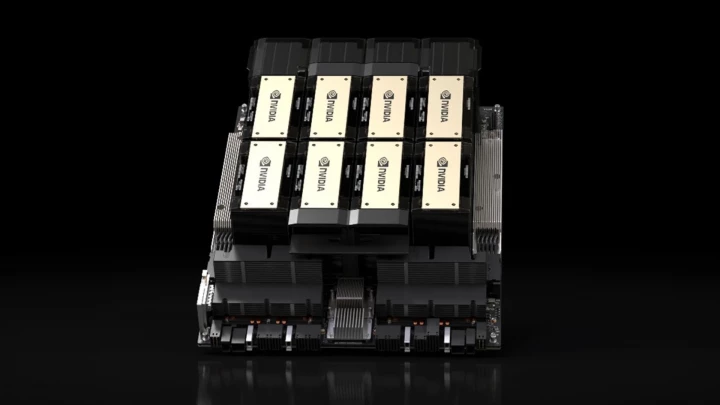

GPUs sind nicht nur hinsichtlich der Leistung, sondern auch hinsichtlich der Energieeffizienz während der LLM-Inferenz von Vorteil. Während CPUs LLMs ebenfalls ausführen können, liefern GPUs aufgrund ihrer weitaus besseren Parallelisierungsfähigkeiten deutlich schnellere Ergebnisse bei geringerem Energieverbrauch. Darüber hinaus verbessern gängige Lösungen in modernen KI-Infrastrukturen, wie z. B. Multi-GPU-Skalierung oder dedizierte KI-Beschleuniger (z. B. NVIDIA A100, H100, H200, AMD Instinct MI300-Serie, Intel Gaudi 3), die Verarbeitungsgeschwindigkeit weiter und ermöglichen die Nutzung von LLMs in Chatbots, Suchmaschinen und anderen KI-basierten Anwendungen in Echtzeit oder nahezu in Echtzeit.

Wichtige NVIDIA-GPUs für die LLM-Inferenz

| GPU-Modell | Architektur | Zielmarkt | Tensor-Kern-Generation | CUDA-Kerne | Tensor-Kerne | Speicher | Speicherbandbreite | Leistungsaufnahme (TDP) |

|---|---|---|---|---|---|---|---|---|

| NVIDIA H200 SXM | Hopper | Rechenzentrum | 4. | 16.896 | 528 | 141 GB HBM3e | 4,8 TB/s | Bis zu 700 W |

| NVIDIA H100 SXM | Hopper | Rechenzentrum | 4. | 16.896 | 528 | 80 GB HBM3 | 3,35 TB/s | Bis zu 700 W |

| NVIDIA A100 (80 GB) | Ampere | Rechenzentrum | 3. | 6.912 | 432 | 80 GB HBM2e | ~2 TB/s | 400 W |

| NVIDIA L40S | Ada Lovelace | Rechenzentrum | 4. | 18.176 | 568 | 48 GB GDDR6 | 0,86 TB/s | 350 W |

| NVIDIA T4 | Turing | Rechenzentrum | 2. | 2.560 | 320 | 16 GB GDDR6 | 0,32 TB/s | 70 W |

| NVIDIA Tesla P40 | Pascal | Rechenzentrum | N/A | 3.840 | N/A | 24 GB GDDR5 | 0,34 TB/s | 250 W |

| NVIDIA RTX 5090 | Blackwell | Consumer / Prosumer | 5. | 21.760 | 680 | 32 GB GDDR7 | 1,79 TB/s | 575 W |

| NVIDIA RTX 4090 | Ada Lovelace | Consumer / Prosumer | 4. | 16.384 | 512 | 24 GB GDDR6X | 1 TB/s | 450 W |

Hinweis: Spezifikationen wie CUDA-/Tensor-Kernanzahl können je nach spezifischem Kartenmodell (z. B. SXM vs. PCIe) leicht variieren. Die gezeigten Werte sind typische Werte oder Maximalwerte für das angegebene Modell/die angegebene Architektur. Die Tensor-Kernanzahl der RTX 5090 ist geschätzt.

Vorteile und Nachteile

| GPU-Modell | Vorteile | Nachteile |

| NVIDIA H200/H100 | - Spitzenleistung für massive LLMs - Enorme Speicherkapazität und Bandbreite (HBM) | - Extrem hohe Kosten - Hoher Stromverbrauch und Wärmeentwicklung |

| NVIDIA A100 | - Ausgezeichnete Leistung, weit verbreitet - Für viele Modelle immer noch sehr leistungsfähig | - Immer noch teuer - Hoher Stromverbrauch |

| NVIDIA L40S | - Starke Leistung für Inferenz/Grafik - Besseres Preis-Leistungs-Verhältnis als H100 für einige Aufgaben - Energieeffizienter als Top-Tier | - Geringere Speicherbandbreite (GDDR6) - Immer noch eine erhebliche Investition |

| NVIDIA RTX 5090 / 4090 | - Ausgezeichnetes Preis-Leistungs-Verhältnis - Leicht verfügbar (Consumer-Markt) - Relativ erschwinglich für die Leistung | - Geringere Speicherkapazität im Vergleich zu Rechenzentrumskarten - Nicht für den Dauerbetrieb im Rechenzentrum ausgelegt (Treiber, Kühlung, Support-Einschränkungen) |

| NVIDIA T4 | - Geringer Stromverbrauch - Kostengünstig für Inferenz - Weitgehend auf Cloud-Plattformen unterstützt | - Geringere Rohleistung - Begrenzter Speicher |

Auswahlkriterien

Bei der Auswahl der richtigen GPU sollten Sie Folgendes berücksichtigen:

- Die Größe des/der Modelle(s), die Sie ausführen möchten

- Leistungsanforderungen (Latenz, Durchsatz)

- Verfügbares Budget

- Stromversorgung und Kühlkapazitäten

Strategien zur Kostenoptimierung

- Infrastruktur entsprechend dem tatsächlichen Bedarf skalieren (keine Überprovisionierung).

- Effiziente Batch-Verarbeitung und Gemischtpräzisions-Inferenz verwenden.

- Modellarchitektur optimieren (falls möglich).

- Modellkomprimierungstechniken anwenden (Quantisierung, Pruning).

- Cloudbasierte GPU-Ressourcen gegenüber dem Aufbau einer On-Premise-Infrastruktur in Betracht ziehen.

GPU-Eignung für KI-Aufgaben

| Kategorie | Eignung | Hauptkriterien |

|---|---|---|

| Exzellent (Top-Tier) | H200, H100, A100 (80 GB) | - 80+ GB High Bandwidth Memory (HBM3e/HBM3/HBM2e) - Neueste Generation dedizierter Tensor-Kerne - Ausgelegt für massive Scale-out |

| Sehr gut | L40S, RTX 5090 | - 32-48 GB Speicher (GDDR7/GDDR6) |

| Gut | A100 (40 GB), RTX 4090, T4 | - 16-40 GB Speicher |

| Begrenzt | Ältere Gaming-GPUs (z. B. RTX 30-Serie, ältere Teslas wie P40) | - Weniger Speicher (oft < 24 GB) - Ältere oder fehlende KI-spezifische Kerne - Geringere Speicherbandbreite |

| Nicht geeignet | Integrierte Grafik, sehr alte GPUs | - Minimaler Speicher - Fehlende parallele Rechenfähigkeit / KI-Funktionen |

Zusammenfassung

NVIDIA ist derzeit nicht nur ein GPU-Hersteller, sondern der Schöpfer eines gesamten KI-Ökosystems. Sein technologischer Vorteil liegt nicht in einer einzelnen Hardwarelösung, sondern in einem komplexen, integrierten System, das modernste Hardware mit einer ausgereiften und weit verbreiteten Softwareplattform kombiniert.